11 月 18 日消息,昨日,上海人工智能實驗室聯合商湯科技 SenseTime、香港中文大學、上海交通大學共同發布新一代通用視覺技術體系“書生”(INTERN),該體系旨在系統化解決當下人工智能視覺領域中存在的任務通用、場景泛化和數據效率等一系列瓶頸問題。

▲ 圖源:上海人工智能實驗室

目前,技術報告《INTERN: A New Learning Paradigm Towards General Vision》已在 arXiv 平臺發布,基于“書生”的通用視覺開源平臺 OpenGVLab 也將在明年年初正式開源,向學術界和產業界公開預訓練模型及其使用范式、數據系統和評測基準等。

根據相關技術報告,一個“書生”基模型即可全面覆蓋分類、目標檢測、語義分割、深度估計四大視覺核心任務。

上海人工智能實驗室表示,相較于當前最強開源模型(OpenAI 于 2021 年發布的 CLIP),“書生”在準確率和數據使用效率上均取得大幅提升。具體而言,基于同樣的下游場景數據,“書生”在分類、目標檢測、語義分割及深度估計四大任務 26 個數據集上的平均錯誤率分別降低了 40.2%、47.3%、34.8% 和 9.4%。

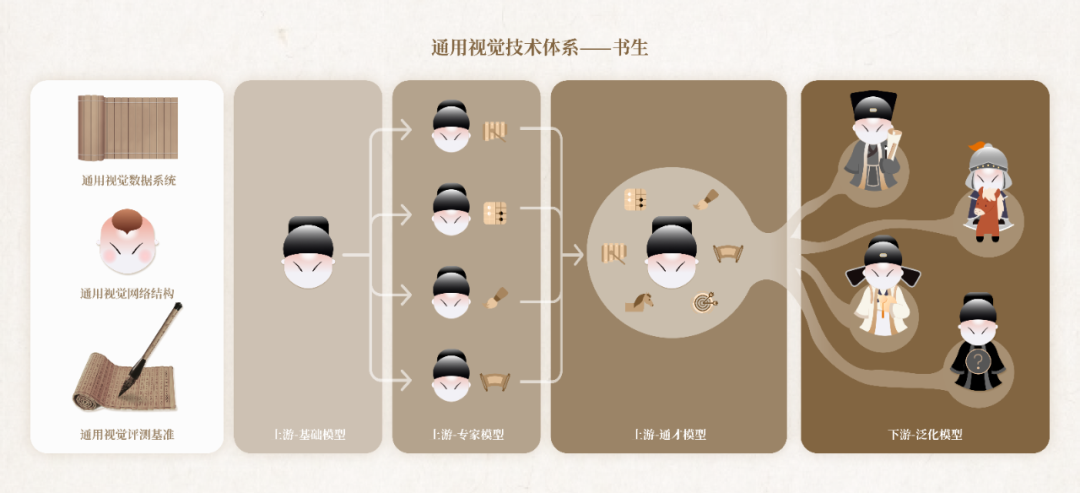

通用視覺技術體系“書生”(INTERN)由七大模塊組成,包括通用視覺數據系統、通用視覺網絡結構、通用視覺評測基準三個基礎設施模塊,以及區分上下游的四個訓練階段模塊。

特別提醒:本網信息來自于互聯網,目的在于傳遞更多信息,并不代表本網贊同其觀點。其原創性以及文中陳述文字和內容未經本站證實,對本文以及其中全部或者部分內容、文字的真實性、完整性、及時性本站不作任何保證或承諾,并請自行核實相關內容。本站不承擔此類作品侵權行為的直接責任及連帶責任。如若本網有任何內容侵犯您的權益,請及時聯系我們,本站將會在24小時內處理完畢。

站長資訊網

站長資訊網